Gemini 3.1 Pro: La Autopsia Técnica (Lo que Google no te contó sobre esos 31 segundos)

Última actualización: 2/20/2026

Gemini 3.1 Pro: La Autopsia Técnica (Lo que Google no te contó sobre esos 31 segundos)

Google lanzó Gemini 3.1 Pro el pasado 19 de febrero y el marketing fue impecable: "Un salto cuántico en razonamiento". Y sí, los números de benchmark son impresionantes. Pero en el Equipo PAI, no nos impresionan los PDFs de marketing; nos impresionan los logs de servidor y las facturas de API.

Hemos pasado las últimas semanas desmantelando este modelo en nuestro laboratorio, analizando su latencia real y comparando costos. La conclusión es agridulce: Google ha construido un Ferrari para el razonamiento abstracto, pero le ha puesto una caja de cambios que tarda medio minuto en arrancar.

Si eres CTO o Lead Dev, necesitas leer esto antes de cambiar una sola línea de código en producción.

⚡ TL;DR: Resumen Ejecutivo (Para el Manager con Prisa)

Si solo tienes 2 minutos entre reuniones, esto es lo que debes saber:

- El Titular: Gemini 3.1 Pro no es una revolución arquitectónica, es una optimización masiva de entrenamiento sobre la base de la v3.

- El Superpoder: Un puntaje de 57 en el Índice de Inteligencia, situándose muy por encima del promedio de modelos comparables.

- El Dolor (Deal-breaker): El Time-To-First-Token (TTFT) puede superar los 30 segundos en modos de alto razonamiento. Inutilizable para chat en tiempo real.

- El Costo Oculto: Aunque el precio por token es competitivo ($12/M salida), el modelo es extremadamente verboso internamente. Tu factura real será más alta.

- Veredicto: Úsalo solo para tareas asíncronas complejas (Coding, Data Analysis, Agentes). Mantente alejado para Chatbots.

🔬 Deep Dive Técnico: La Carne del Asunto

1. Arquitectura: La Evolución del "Pensamiento Rumiante"

No estamos viendo una arquitectura nueva, sino un refinamiento del Chain-of-Thought (CoT) forzado. Gemini 3.1 Pro comparte el espacio latente multimodal nativo de su predecesor (texto, imagen, audio, video procesados juntos), pero cambia radicalmente cómo procesa la respuesta antes de escupirla.

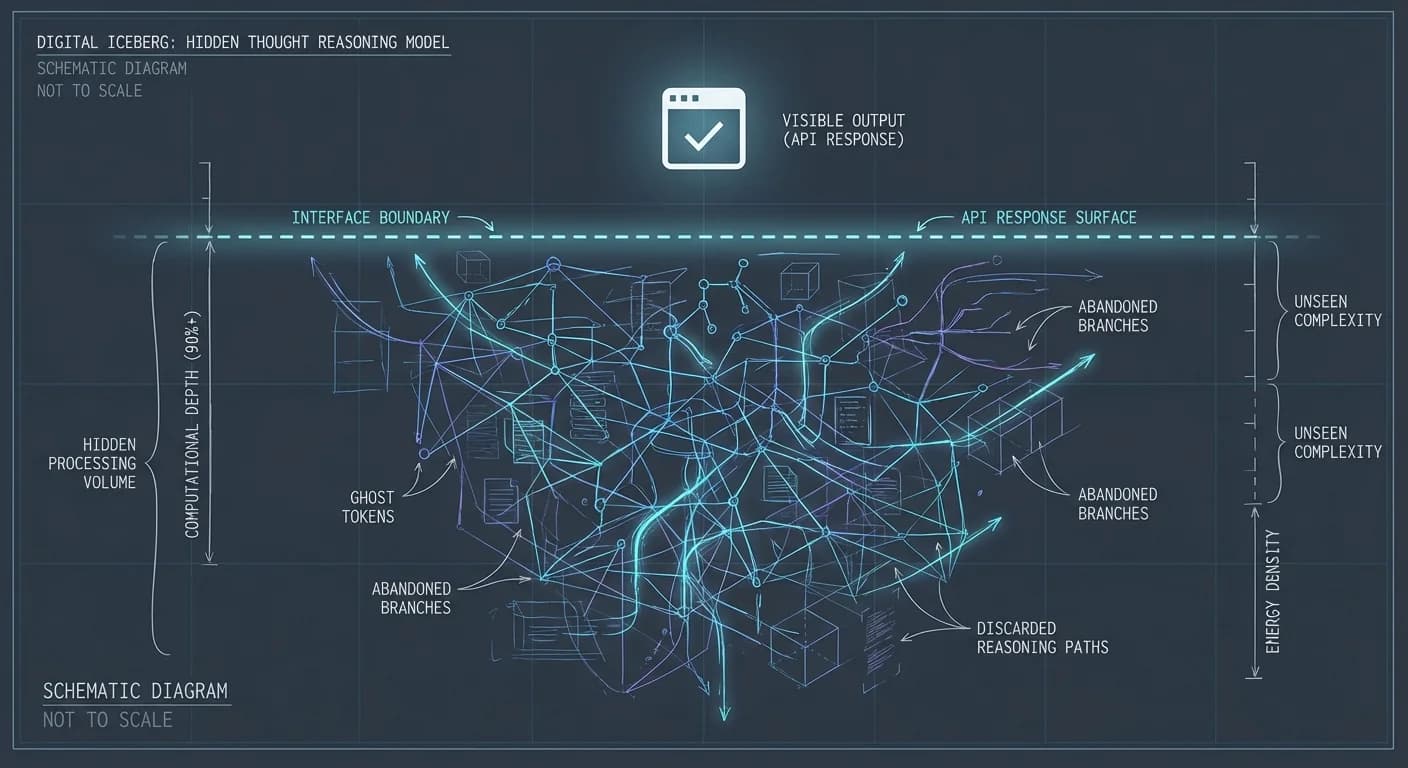

El modelo utiliza un sistema de Pensamiento Oculto. A diferencia de los modelos tradicionales que predicen el siguiente token inmediatamente, Gemini 3.1 genera tokens internos de razonamiento que nunca ves (pero que consumen cómputo).

El flujo de inferencia simplificado:

Cargando diagrama...

2. La Solución al "Truncamiento Maldito"

Uno de los dolores más grandes con la versión anterior era el corte de código a la mitad. La versión 3.1 está diseñada para manejar tareas complejas y grandes datasets, permitiendo salidas mucho más largas.

¿Por qué importa esto a nivel de ingeniería? Porque permite generación de SVGs animados y Dashboards completos en una sola pasada. El modelo ya no necesita "unir" trozos de código; puede mantener el contexto completo de un archivo HTML+JS+CSS complejo en el buffer de salida sin perder coherencia.

3. El Sistema de Niveles de Pensamiento

Google introdujo un control granular sobre la profundidad del pensamiento. Esto es técnicamente elegante porque nos permite gestionar el trade-off de latencia. Sin embargo, las pruebas indican que el modelo supera el promedio en inteligencia, pero a costa de ciclos de computación intensivos.

⚠️ Reality Check: Datos Duros y Trade-offs

Aquí es donde apagamos el proyector de marketing y encendemos las luces del laboratorio.

El Elefante en la Habitación: La Latencia

Vamos a ser brutalmente honestos: Esperar medio minuto para el primer token es una eternidad en tiempos de internet. En comparativas directas, la latencia de Gemini 3.1 Pro Preview vs Gemini 3 Pro muestra que la "inteligencia extra" se paga con tiempo de espera.

¿Qué significa esto en Producción? Si conectas Gemini 3.1 Pro directamente a un chatbot de atención al cliente, tus usuarios pensarán que la app se congeló. El modelo está diseñado para procesamiento por lotes, no para conversación fluida.

El "Impuesto de Verbosidad"

El análisis de costos revela una trampa. El precio de lista es $2.00 por millón de tokens de entrada y $12.00 por salida, exactamente el mismo precio que la versión 3.0 Pro Preview. Razonable, ¿verdad? Incorrecto.

Debido a su proceso de razonamiento, el modelo genera más tokens internos para llegar a la misma conclusión. Aunque Google no cobra los tokens de pensamiento en todas las modalidades, la latencia tiene un costo de oportunidad en tu infraestructura.

🚀 Plan de Acción: El Patrón "AI Router"

No migres todo a Gemini 3.1 Pro. La única forma viable de usarlo hoy es mediante el patrón de diseño Semantic Router.

Aquí tienes una implementación conceptual en Python de cómo deberías estructurar tu backend para no quebrar la empresa ni la paciencia del usuario:

python

Tu Estrategia de Implementación para el Q2:

- El Portero (The Router): Usa un modelo barato y rápido para clasificar la intención. Puedes revisar nuestra guía sobre Prompt Engineering para afinar esta clasificación.

- El Carril Rápido (80% del tráfico): Tareas simples van a modelos Flash. Costo bajo, latencia mínima.

- El Laboratorio (20% del tráfico): Si la tarea requiere "pensar" (generar una app entera, resolver lógica compleja), enruta a Gemini 3.1 Pro.

¿Listo para probarlo? Empieza integrándolo solo en tus pipelines de CI/CD para revisión de código o generación de tests. Es el mejor balance costo-beneficio hoy mismo. Y por favor, si decides usarlo en el frontend, pon un spinner de carga muy entretenido.

— El Equipo PAI