ChatGPT Health: El Fin de la Privacidad Médica (y por qué no puedes dejar de usarlo)

Última actualización: 1/10/2025

Son las 3:17 de la madrugada. Tienes fiebre, Google te dice que tienes tres enfermedades terminales distintas y tu médico de cabecera no tiene cita disponible hasta el próximo abril. En medio de la ansiedad, abres una app, subes tus síntomas y recibes una respuesta empática y lógica en 2 segundos.

Bienvenido a la nueva sala de espera global.

La semana pasada, OpenAI soltó una bomba nuclear silenciosa: 230 millones de personas ya usan ChatGPT para temas de salud. No es una "feature" más; es la prueba de que el sistema de salud tradicional ha colapsado y ha sido reemplazado por un cursor parpadeante.

Pero aquí es donde la historia se pone turbia:

Para lograr esto, OpenAI tuvo que comprar una pieza de tecnología "secreta" por 100 millones de dólares y crear un agujero legal en tu privacidad que haría sonrojar a Zuckerberg. Hoy vamos a destripar la arquitectura técnica detrás de ChatGPT Health, por qué es un RAG glorificado y la trampa mortal de la HIPAA en la que podrías estar cayendo.

¿Qué es realmente ChatGPT Health? (El Diagrama de Servilleta)

Olvídate del marketing. A nivel técnico, ChatGPT Health no es un médico; es un traductor de burocracia.

El problema de la salud no es la falta de datos, es el formato. Tu reloj tiene tu pulso, el laboratorio tiene tu sangre en un PDF y el hospital tiene tu historial en un sistema arcaico (como Epic) que no habla con nadie.

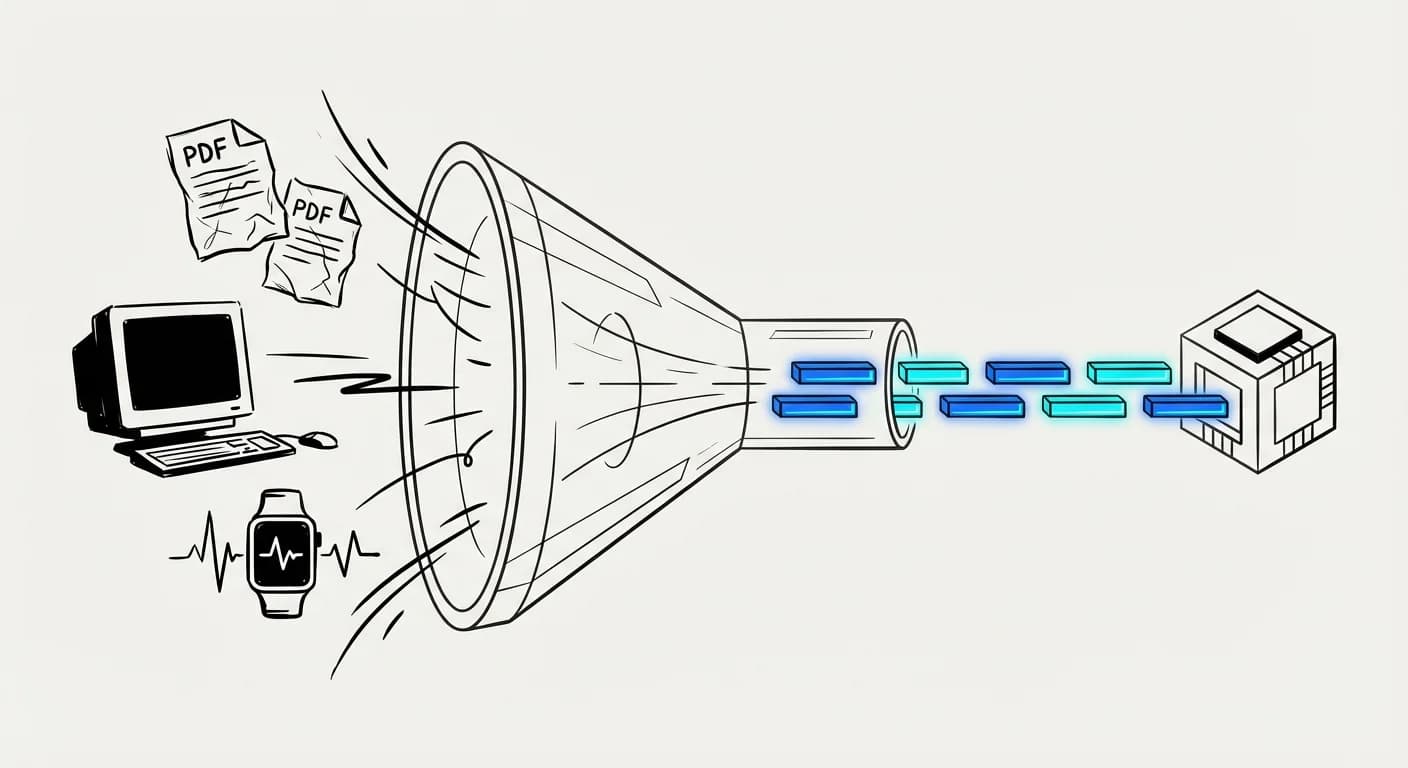

El Diagrama de Servilleta: El "Embudo Torch"

Imagina este flujo, que es lo que realmente ocurre bajo el capó:

- Input Caótico: PDF de análisis + Datos de Apple Health + Historial de Epic.

- El Normalizador (Torch): Aquí está la magia. La startup que OpenAI compró (Torch) actúa como un middleware que ingiere estos formatos rotos y los convierte en un JSON estructurado y cronológico.

- Context Window: Ese JSON limpio se inyecta en la ventana de contexto del modelo.

- Output: El LLM no "piensa" en medicina, solo procesa el contexto limpio que Torch le sirvió.

Si te interesa cómo construir sistemas que ingieren datos desordenados, revisa nuestra guía sobre RAG y Contexto en IA Aplicada. Es el mismo principio: basura entra, basura sale. Torch es el filtro de basura.

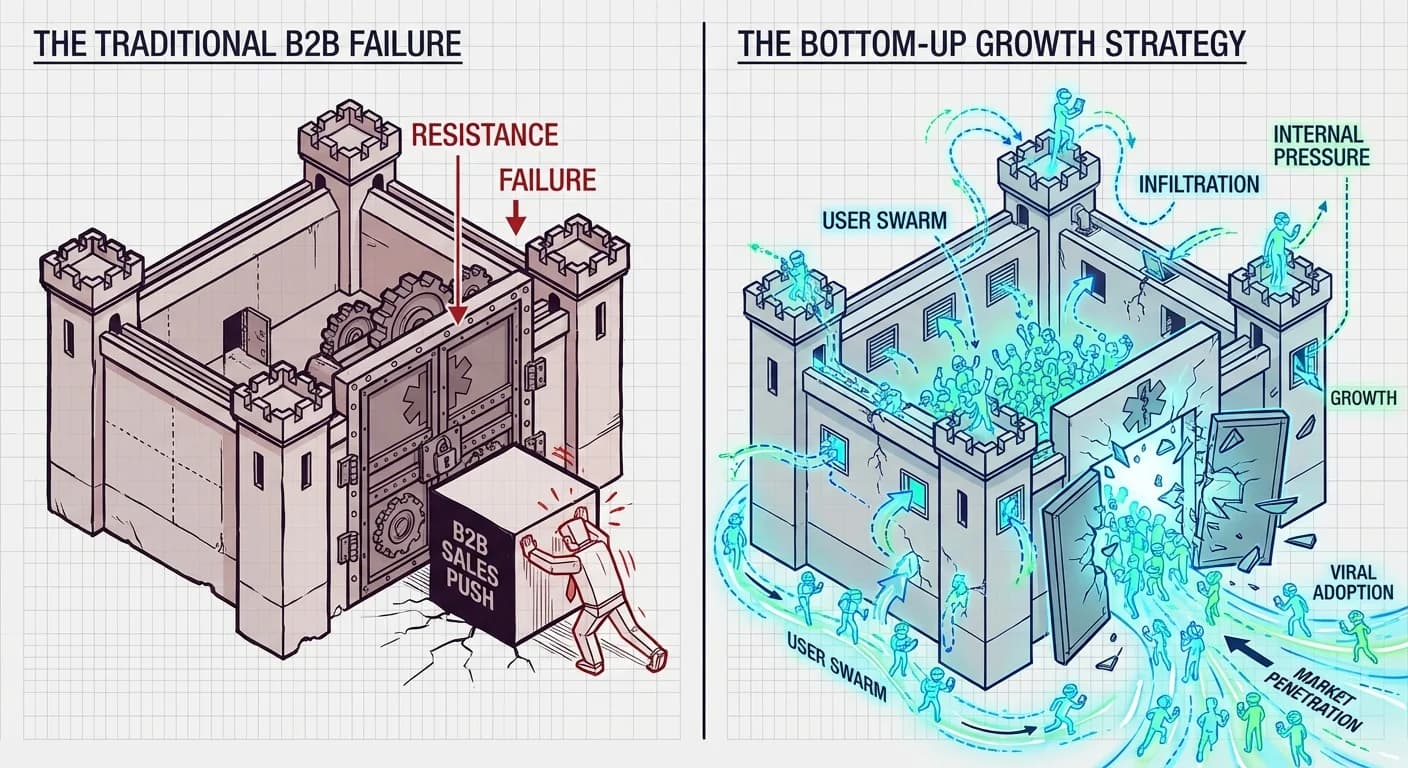

El Fracaso Previo: Por qué Google y Apple fallaron antes

Antes de que te emociones, recordemos al "Anti-Héroe": Google Health (el original) y IBM Watson. Fracasaron estrepitosamente.

¿Por qué? Porque intentaron venderle la tecnología a los hospitales primero. Intentaron entrar por la puerta grande de la burocracia B2B. OpenAI ha hecho lo contrario: Growth Hacking puro. Han ido directo al consumidor desesperado (tú a las 3 AM) para forzar la mano de la industria.

Es una estrategia de Desarrollo de Producto brillante: crear una dependencia en el usuario final para que los hospitales no tengan más remedio que adoptar la herramienta.

El "Hot Take": La Gran Estafa de la Privacidad (Adiós HIPAA)

Aquí es donde necesito que apagues el piloto automático y leas con atención.

OpenAI ha creado lo que llamamos la "Paradoja de la Privacidad". El producto es técnicamente seguro (encriptación, SOC2), pero legalmente es un campo minado.

La realidad es esta:

- En el Hospital: Tus datos están protegidos por la ley HIPAA (en EE.UU.) o GDPR (en Europa). Es ilegal que los compartan sin tu permiso explícito.

- En ChatGPT (Consumo): En el momento en que tú, voluntariamente, conectas tus registros a través de la integración de b.well, estás sacando tus datos del paraguas de la HIPAA y entregándolos a una empresa de consumo.

Piénsalo 5 segundos: ¿Le darías tu historial psiquiátrico a Facebook a cambio de que te quite la publicidad? Porque esencialmente estás haciendo un intercambio similar aquí: privacidad legal a cambio de conveniencia inmediata.

Al igual que explicamos en nuestros análisis sobre seguridad en WhatsApp y Automatización, la comodidad es el enemigo número uno de la privacidad.

Veredicto Técnico: ¿Funciona o Alucina?

Un estudio reciente de Stanford lanzó un balde de agua fría: el acceso a ChatGPT no mejoró significativamente la precisión diagnóstica de los médicos.

El problema es el Sesgo de Automatización. El modelo suena tan convincente, tan empático y tan seguro de sí mismo, que incluso los médicos bajan la guardia. Si el modelo dice "Posible apendicitis" con un 90% de confianza simulada, es difícil llevarle la contraria.

Los 3 Errores Fatales:

- Alucinación de Protocolos: Inventa interacciones medicamentosas que parecen lógicas pero no existen.

- Falsa Empatía: En salud mental, puede validar comportamientos peligrosos bajo la guisa de ser "comprensivo".

- Ceguera de Contexto: Si Torch falla en la normalización (ver diagrama arriba), el modelo razona sobre datos incompletos sin saberlo.

Conclusión: Un Parche Digital en una Herida Abierta

ChatGPT Health es una proeza de ingeniería construida sobre un cementerio de fallos sistémicos. Es un "parche digital".

Para el usuario en un área rural, es un milagro. Para el CTO preocupado por la privacidad, es una pesadilla. Para OpenAI, es la validación final de que los datos verticales son el nuevo petróleo.

🚀 Desafío Semanal: El Auditor de la Muerte

Esta semana, vamos a probar la capacidad de autocrítica de los modelos (sin usar tus datos reales, por favor).

- Inventa un caso clínico complejo (o usa uno de una serie como Dr. House).

- Pásalo por ChatGPT o Claude y pide un diagnóstico.

- El giro: Una vez que te dé la respuesta, escribe este prompt exacto:

"Actúa como un Auditor Forense Médico que odia este diagnóstico. Lista 5 razones basadas en evidencia por las que esta conclusión podría matar al paciente."

Te sorprenderá ver cómo el modelo destruye su propia lógica en segundos. Si encuentras una contradicción brutal, compártela conmigo en LinkedIn.

El futuro es IA, pero la responsabilidad sigue siendo humana.