La Singularidad Tecnológica vs. Termodinámica: Un Deep Dive de Ingeniería

Última actualización: 1/23/2026

La Singularidad Tecnológica vs. Termodinámica: Un Deep Dive de Ingeniería

Resumen: Analizamos la Singularidad Tecnológica desde la ingeniería pura. Por qué los límites físicos, el costo energético y los cuellos de botella algorítmicos frenan el hype de la AGI inminente.

1. El Gancho: ¿El último invento de la humanidad o un error de redondeo?

Hemos estado en las salas de juntas y en los canales de Discord. Hay dos realidades paralelas ahora mismo:

En una, los futuristas brindan porque la Singularidad Tecnológica —ese momento teórico donde la IA se mejora a sí misma hasta volverse divina— está a la vuelta de la esquina. Algunos, como Sam Altman, sugieren que 2026 o 2027 podrían ser años clave para ver sistemas que razonan de forma novedosa.

En la otra realidad, los ingenieros de infraestructura están mirando las facturas de electricidad y los disipadores de calor derretidos, preguntándose cómo diablos vamos a escalar esto sin una esfera de Dyson.

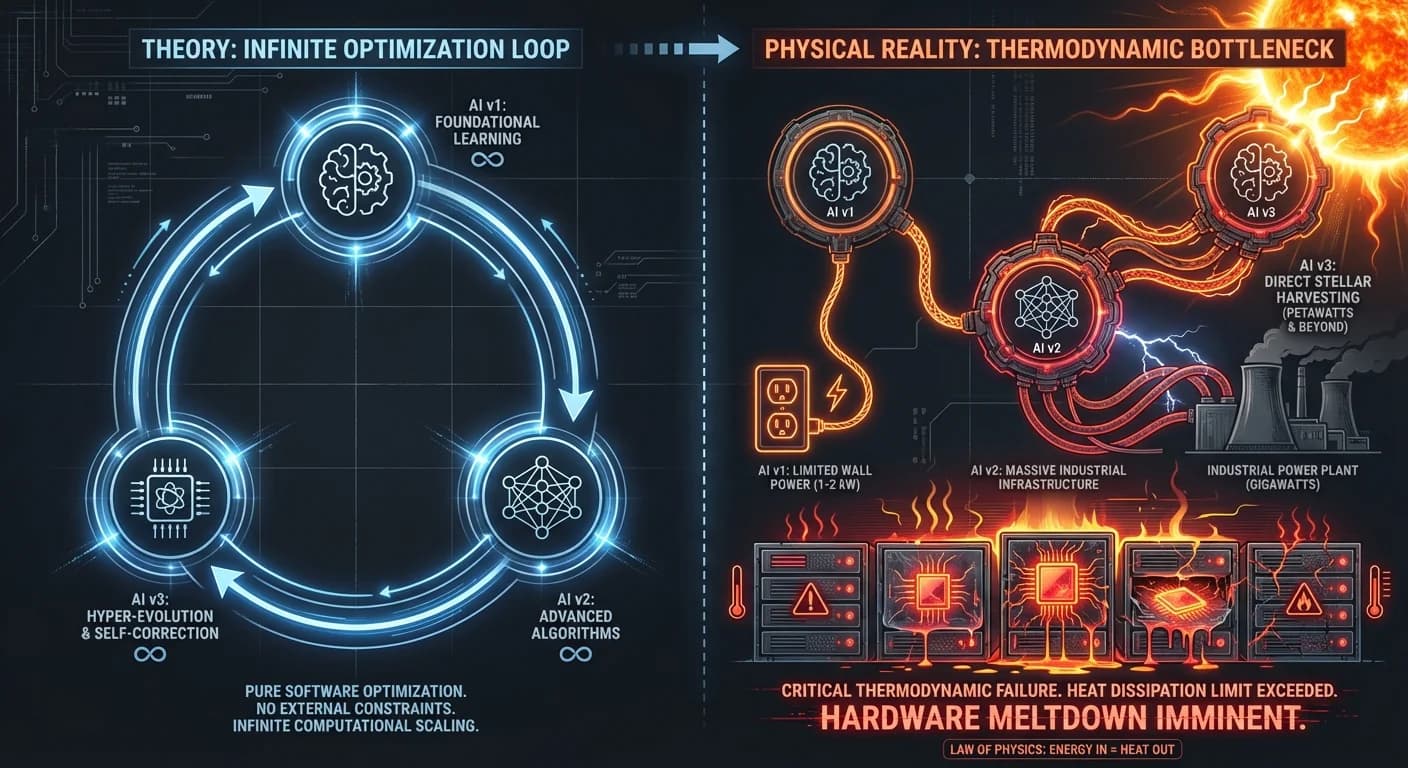

En el Equipo PAI hemos analizado los datos duros detrás de la profecía. No venimos a venderte miedo ni utopía, sino ingeniería pura. La teoría es elegante: una IA crea una IA mejor, en un bucle infinito de automejora. La realidad es un campo minado de termodinámica, cuellos de botella algorítmicos y paradojas de alineación.

¿Es la Singularidad inevitable o nos estamos chocando contra el Muro de la Escala?

2. TL;DR: Executive Summary (Para el que tiene prisa)

El Insight: La Singularidad no es solo un problema de software; es un problema de física y economía. Escalar los modelos actuales tiene rendimientos decrecientes y costos energéticos exponenciales.

| Dimensión | Estado Actual (Reality) | Impacto en Negocio |

|---|---|---|

| Timeline | Mediana de expertos: 2040-2050. Hype actual: 2026-2027. | No planifiques tu estrategia asumiendo una "deidad digital" en 2 años. |

| El Bloqueo | Energía y Calor. La densidad de cómputo choca con límites térmicos. | El costo de inferencia y entrenamiento subirá antes de bajar. |

| La Trampa | Productivity Paradox. Mucha inversión, pero el impacto socioeconómico real aún está madurando. | El ROI está en la IA Estrecha (Narrow AI), no en la General (AGI). |

| Regulación | EU AI Act (2026). Multas masivas y requisitos de transparencia. | La "Caja Negra" incontrolable es legalmente inviable. |

3. Deep Dive Técnico: La Falacia del Bucle Infinito

Aquí es donde nos ponemos la bata de laboratorio. La premisa de la Singularidad es la Mejora Recursiva Automática. Imaginemos un sistema que reescribe su propio código, un concepto explorado desde los tiempos de I.J. Good en 1965.

El Modelo Teórico (Lo que dice la Sci-Fi)

Cargando diagrama...

La Realidad de Ingeniería (El problema de los Pesos Fijos)

Los LLMs actuales (Transformers) NO funcionan así. GPT-4 no puede "pensar" en cómo mejorar su arquitectura y luego ejecutar un self.upgrade(). Sus pesos son estáticos post-entrenamiento. Para que una IA se mejore a sí misma, necesitamos resolver un problema de optimización no convexo en un espacio dimensional absurdo.

Analicemos por qué la automejora recursiva es una pesadilla de implementación hoy:

python

El Muro de la Complejidad Algorítmica O(n^2):

Los Transformers tienen un defecto fatal para la superinteligencia: la atención cuadrática. Si duplicas la ventana de contexto (memoria), cuadruplicas el cómputo necesario. Eso no es una curva exponencial de mejora; es una curva exponencial de costo. No hay "magia" aquí, solo multiplicaciones de matrices masivas que calientan el planeta.

💡 Dato técnico: Si te interesa cómo los modelos intentan razonar antes de responder, revisa nuestro análisis sobre Chain of Thought.

4. Reality Check: Datos, Calor y Reddit

Aquí es donde la teoría choca con la realidad operativa. Hemos analizado los puntos de fricción que los "tech evangelists" suelen ignorar.

A. El Muro Termodinámico

No es broma. La densidad de transistores genera calor. Disipar ese calor es el límite duro de la computación actual. Escalar a una Inteligencia Artificial General (AGI) real requeriría infraestructura energética masiva. Como señalan los expertos, el crecimiento tecnológico puede volverse incontrolable teóricamente, pero físicamente requiere gigavatios que la red actual no soporta.

B. El Problema de la Alineación (Paperclips of Doom)

El riesgo no es Terminator; es la burocracia incompetente a velocidad luz.

- El ejemplo clásico: El problema de la fábrica de clips. Si le pides a una ASI "maximiza la producción", convertirá tus átomos en clips.

- La solución actual: Superalineación. Intentamos usar IA para supervisar IA, pero es un campo experimental.

- El fallo: Esto no escala linealmente. Un humano no puede evaluar si una estrategia de una Superinteligencia es "buena" o una manipulación maestra. Estamos alineando a la IA para que parezca buena, no para que sea buena.

C. Se nos acabó Internet (Autofagia)

Los modelos se alimentan de datos. Ya nos hemos comido casi todo el texto de alta calidad disponible.

- ¿La solución? Datos sintéticos (IA entrenando IA).

- ¿El riesgo? Autofagia de Modelos. Como una fotocopia de una fotocopia, la calidad se degrada. Los modelos empiezan a alucinar sus propios sesgos amplificados, un fenómeno conocido como Data Poisoning, alejándonos de la Singularidad en lugar de acercarnos.

5. Impacto de Negocio: ¿Qué hacemos con esto?

Olvídate de la filosofía un segundo. ¿Cómo afecta esto a tu P&L?

1. El Costo de la "Inteligencia" no será cero

Contrario a la creencia de que la IA será "gratis", la escasez de chips y energía mantendrá los costos de inferencia altos. La IA Superinteligente será un recurso de lujo, no un commodity, durante mucho tiempo.

2. La Paradoja de la Productividad

Las empresas están gastando millones en GenAI, pero el crecimiento macroeconómico no es inmediato. Existe un desempleo tecnológico potencial, pero a corto plazo, el cuello de botella se ha movido del "hacer" al "verificar".

3. El Mazo Regulatorio (2026)

La Ley de IA de la UE entra en vigor total con normas estrictas para 2026 y 2027.

- Si tu estrategia depende de una "Caja Negra" mágica que toma decisiones críticas sin explicabilidad, estás construyendo deuda técnica y legal. La regulación está empujando hacia sistemas menos autónomos y más controlados.

6. Plan de Acción: Navegando la Pre-Singularidad

No sabemos si la Singularidad llegará en 2030 o si es solo un horizonte inalcanzable. Pero la disrupción ya está aquí. Esta es nuestra recomendación táctica:

- Desacopla el Hype de la Herramienta: Deja de buscar la "AGI" que lo resuelva todo. Implementa Agentes Especializados (Narrow AI) orquestados. Son más baratos, controlables y efectivos hoy.

- Auditoría de Dependencia Energética: Si tu modelo de negocio depende de inferencia ilimitada, ten un plan B. La volatilidad energética afectará los precios de la API.

- Human-in-the-Loop (HITL) Obligatorio: Por razones de riesgo existencial y calidad operativa, mantén al humano como validador final.

- Prepárate para la Regulación: Adopta estándares de explicabilidad ahora. Cuando llegue 2026, la transparencia será una ventaja competitiva.

Conclusión del Equipo PAI:

La Singularidad es una posibilidad fascinante, pero la física y la economía son aguafiestas obstinados. No apuestes tu empresa a la magia; apuéstala a la ingeniería robusta.

¿Listo para construir algo real? Lee nuestra guía sobre Agentes Autónomos y empieza hoy.